Sanovの定理はCramerの定理の特別な場合である

#数楽 http://www.math.tohoku.ac.jp/~kuroki/LaTeX/20160616KullbackLeibler.pdf …KL情報量とSanovの定理Ver.0.15(58頁、2頁増えた)Sanovの定理が拡張されたCramerの定理の特別な場合になっていることの簡単な説明を追加した。

#数楽 Cramerの定理は分配函数やらカノニカル分布を使って定式化・証明される易しい大偏差原理。Sanovの定理は経験分布がどこに集中するかを記述する大偏差原理。Sanovの定理は確率分布に値を持つ確率変数列に(拡張された)Cramerの定理を適用すればただちに得られる。

#数楽 分配函数とカノニカル分布から出発するCramerの定理は正準集団の統計力学の各種計算をしたことがある人であれば親しみ易いと思う。Sanovの定理はその親しみ易いCramerの定理(の拡張版)の特別な場合になっている。

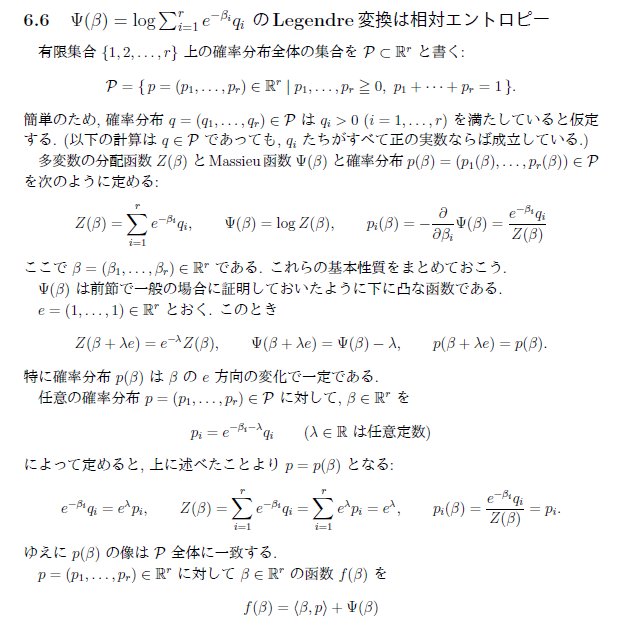

#数楽 続き。Cramerの定理からSanovの定理を導くときの計算は実質的に、Z(β_1,…,β_r)=Σ_i e^{-β_i} q_i のルジャンドル変換が S(p_1,…,p_r)=-Σ_i p_i log(p_i/q_i) =(相対エントロピー)になるという単純な計算。

#数楽 続き。訂正。文字数のプレッシャー―に負けた。Z(β_1,…,β_r)=Σ_i e^{-β_i} q_i そのものではなく、その対数のルジャンドル変換が相対エントロピー S(p_1,…,p_r)=-Σ_i p_i log(p_i/q_i) になる。

#数楽 相対エントロピーは多項分布の確率の対数の漸近挙動として、k_i=np_iのとき (1/n)log[(n!/(k_1!…k_r!))q_1^{k_1}…q_r^{k_r}]→-Σ_i p_i log(p_i/q_i) と出て来るのですが、全然別の方法でも同じ式が出て来る。

#数楽 私個人の感覚では、Shannonエントロピーやその-1倍であるShannon情報量およびそれらの相対版の相対エントロピーやKLダイバージェンスの式を天下り的に出されても、全然わかった気になれない。ある極限で必然的にそれらが出て来るという話が欲しい。

#数楽 母集団分布qとサンプルサイズnのもとで経験分布pが得られる確率の対数とのn分の1の-1倍のn→∞での極限がKullback-Leibler情報量D(p||q)になるというのが、Sanovの定理の超大雑把な説明。KL情報量の必然性を主張している。

#数楽 Cramerの定理は母集団分布(統計力学では等確率の原理を仮定するが、仮定しない方が応用先が広くなる)での確率とカノニカル分布での確率のあいだの関係を記述する定理。ボルツマン因子を使う計算から出発して自然な議論を行えば示せる。

#数楽 Sanovの定理から、最小KL情報量の原理を経由して、ボルツマン因子を自然に出せるので、Sanovの定理はCramerの定理を本質的に含んでいると言えます。

#数楽 しかし、クラメールの定理で使うカノニカル分布を逆温度にあたる変数を複数個に増やす形で拡張すると、Sanovの定理の意味での経験分布の分布の挙動を拡張されたカノニカル分布で記述可能であることがわかります。

#数楽 以上で説明した話を http://www.math.tohoku.ac.jp/~kuroki/LaTeX/20160616KullbackLeibler.pdf … 「KL情報量とSanovの定理」に数時間前に追加しました。専門外なせいで、数時間前以前には、Sanovの定理が本質的にCramerの定理の特別な場合であることに気付いてなかった。

#数楽 そのことに気付いていたなら、Sanovの定理ではなく、Cramerの定理の定理の解説からノートを書き始めていたと思う。Cramerの定理ではカノニカル分布を仮定して話を始めるので、Sanovの定理より特別な場合しか扱っていないと誤解していたのだ。

#数楽 Sanovの定理もCramerの定理もどちらも一般の場合の統計力学を扱えるほど強力ではないのですが、(相対)エントロピーやらカノニカル分布やらが必然的にかつ勝手に出て来てしまうことを納得せざるを得なくなる程度には強い結果です。

#数楽 そして、逆温度のあたるものが複数になるようにカノニカル分布の概念を拡張すると、Sanovの定理(KL情報量の必然性を主張する定理)はCramerの定理の特別な場合になってしまう。カノニカル分布の概念が基本的かつ強力なことがよくわかる話。

#数楽 誤解の原因はKL情報量Σp_i log(p_i/q_i)のp_iたちの函数としてのルジャンドル変換を計算してなかったこと。結果はlog[Σe^{-β_i}q_i]になる。これは明らかに逆温度が複数のカノニカル分布の分配函数の対数の形になっている。

#数楽 「具体的な凸函数を見たら、なにはともあれ、ルジャンドル変換を計算してみるべきである」という基本にしたがわなかったのが敗因。さらにその原因は多変数凸函数のルジャンドル変換の計算をほとんどしたことがなかったこと。計算の経験はとても大事。誤解を防げる。

#数楽 等確率の原理を仮定しない場合のカノニカル分布が、確率分布のエッシャー変換(Esscher変換)と呼ばれている場合があることに気付いたのも最近の話。金融関係の仕事をしている人達にはそちらの呼び名の方が馴染み深いかも。

#数楽 というわけで、ノート http://www.math.tohoku.ac.jp/~kuroki/LaTeX/20160616KullbackLeibler.pdf … は金融関係者にも役に立つかも。ただし、「カノニカル分布」と書いてあったら、「確率分布のエッシャー変換」と読み替えなければいけない。

#数楽 そのノートを書くに至った動機は、カノニカル分布=確率分布のエッシャー変換が出て来る必然性について解説すること。基本定理はSanovの定理とCramerの定理。基本概念は相対エントロピー=−Kullback-Leibler情報量、大偏差原理。

#数楽 「大偏差原理」という言い方をするとなんとなくすごそうに聞こえるのですが、「確率がからむ話におけるLaplaceの方法が適用できる状況設定」と読み変えると昔からよくやる類の計算の変種だと思えます。用語は常に本質的ではない。概念そのものが大事。

#数楽 http://www.math.tohoku.ac.jp/~kuroki/LaTeX/20160616KullbackLeibler.pdf …『Kullback-Leibler情報量とSanovの定理』Ver.0.16(60頁)ψ(β)=logΣe^{-β_i}q_iのルジャンドル変換が相対エントロピーになること(およびその逆)の詳しい計算を追加した.

#数楽 追加した部分は「複数の逆温度の場合に拡張されたCramerの定理がSanovの定理を含む」という事実を示すときの計算の実質的部分です。〇〇エントロピーや〇〇情報量のような凸函数を見たら、ルジャンドル変換を計算してみることが大事。

#数楽 現在 http://math.tohoku.ac.jp/~kuroki/LaTeX/ にアクセスできなくなっています。最近ずっと使いまわしている解説のコピーを以下の場所に置いておきました。http://genkuroki.web.fc2.com/20160501StirlingFormula.pdf …http://genkuroki.web.fc2.com/20160616KullbackLeibler.pdf …